Wir haben das Engpasskonzept viele Male gelesen und gehört, aber es gibt einen davon, der historisch in jedem PC zu finden ist, den wir in unseren Händen haben, und der auch Jahrzehnte später nicht gelöst wurde. Was ist der größte Engpass, der in unseren Computern existiert?

Ein System ist nicht so schnell, wie es seine schnellste Komponente sein kann, sondern so schnell, wie es seine langsamste Komponente zulässt. Was würde passieren, wenn wir Ihnen sagen würden, dass es ein einschränkendes Element gibt, das sich nicht über Jahrzehnte entwickelt hat, sondern über Jahrzehnte? Nun, der Engpass, über den wir sprechen werden, ist keine bestimmte Konfiguration, sondern ein allgemeiner Trend bei allen Computern. Was auch immer es ist, Sie werden es finden und derzeit ist es unüberwindbar.

Was ist der größte Engpass auf einem PC?

Um die Leistung eines Prozessors im Vergleich zu einem anderen zu messen, nehmen Sie dasselbe Programm in beiden, um zu sehen, wie lange jeder benötigt, um es auszuführen. Offensichtlich ist derjenige, der weniger Zeit benötigt, schneller. Das Problem ist, dass die Messung der Leistung heute aufgrund der enormen Anzahl von Faktoren, die heute existieren, schwierig ist. Wir brauchen also synthetische Benchmarks und den Einsatz von Applikationen, um die Leistungsfähigkeit der Hardware zu testen und uns ein quantitatives und qualifiziertes Bild davon machen zu können.

Es gibt jedoch einen Engpass, der in allen Systemen allgemein ist, da es die ganze Zeit über stabil war. Außerdem jongliert man in dieser Hinsicht seit Jahren auf einem Drahtseil und jedes Mal aufs Neue RAM Beim Design des Speichers und seiner Schnittstelle wird darauf geachtet, dass er nicht verschwendet wird und die Leistung des Zentralprozessors beeinträchtigt. und damit der Rest des Systems.

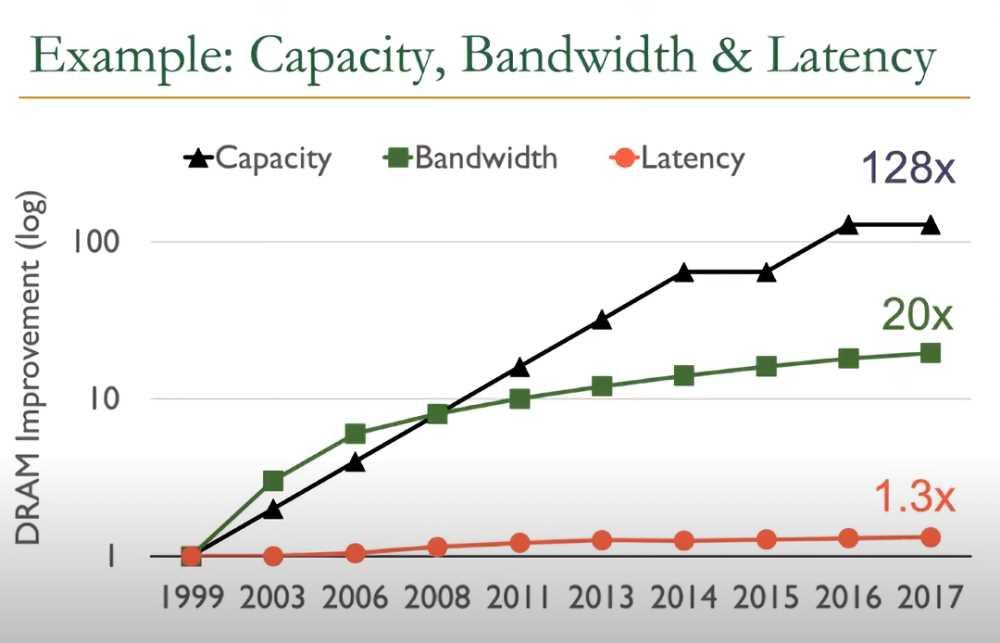

Nun, wenn wir die technische Entwicklung des RAM-Speichers in den letzten zwei Jahrzehnten beobachten, werden wir sehen, wie:

- Die Speicherkapazität ist um das 128-fache gestiegen.

- Die Bandbreite ist jetzt 20-mal größer.

- Die Latenz ist jedoch nur 30 % niedriger.

Es ist der letzte Punkt, der bisher den größten Engpass darstellt. Den Arbeitsspeicher näher an den Prozessor zu bringen, wäre die beste Option, würde die Systeme jedoch verteuern, und obwohl es auch eine Lösung für den Verbrauch ist, bedeutet es einen vollständigen Bruch mit der traditionellen Art, PCs herzustellen. Obwohl wir früher oder später die Art und Weise ändern müssen, wie wir RAM verstehen.

Höhere Bandbreite bedeutet nicht geringere Latenz

Wenn ein Hersteller die Bandbreite eines Speichers angibt, gibt er ihn unter optimalen Bedingungen an, die unmöglich sind, und daher für eine einzige kontinuierliche Übertragung in einem bestimmten Zeitraum. Allerdings ist die Sache nicht so einfach und wir müssen berücksichtigen, dass der Speichercontroller die Zugriffe auf den RAM durch mehrere Kerne des Prozessors und zugehöriger Coprozessoren verwalten muss.

- Der integrierte Speichercontroller oder IMC hat eine maximale Anzahl von Anforderungen, die er verarbeiten kann. Wenn am Ende eine tolerierbare Menge überschritten wird, verlangsamt es sich, verzögert die restlichen Anfragen und erzeugt Latenz.

- Jeder neue Speicherzugriff durch einen anderen Client impliziert eine akkumulierte Latenzzeit.

Zum Beispiel werden Sie gesehen haben, wie jede neue Generation von Intel und AMD Prozessoren unterstützen immer schnelleren RAM, aber nie den schnellsten auf dem Markt. Dies liegt daran, dass es den Punkt erreicht, an dem die tolerierbare Latenz überschritten wird und zu einem Leistungsengpass wird. Darüber hinaus haben übertaktete Speicher langsamere Kommunikationszeiten, ihre Spitzenbandbreite ist ideal für bestimmte Anwendungen, aber sie leiden unter leichten Latenzproblemen.