Das Konzept, künstliche Intelligenz vor Ort zu nutzen, insbesondere durch Tools wie ChatGPT, hat in letzter Zeit bei Technikbegeisterten und Fachleuten gleichermaßen an Bedeutung gewonnen. Ein herausragendes Beispiel für diesen Trend ist die Initiative von StorageReview, die ein mit einem erweiterten NAS-Setup nutzte NVIDIA RTX A4000, um ChatGPT vollständig offline auszuführen.

Dieser Ansatz unterstreicht das wachsende Interesse daran, den Datenschutz und die Kontrolle über Daten zu wahren und gleichzeitig die Leistungsfähigkeit der KI zu nutzen.

Die Vorteile der lokalen KI-Implementierung

1. Verbessert Datenschutz und Sicherheit: Durch die lokale Ausführung von KI wie ChatGPT auf einem NAS-System mit robuster Hardware wird sichergestellt, dass vertrauliche Daten innerhalb der Grenzen eines privaten Netzwerks bleiben. Dieses Setup mindert die mit Datenschutzverletzungen und externen Bedrohungen verbundenen Risiken und macht es besonders attraktiv für Umgebungen, in denen sensible oder vertrauliche Informationen verarbeitet werden.

2. Maßgeschneiderte KI-Lösungen: Die lokale Bereitstellung ermöglicht die Anpassung und Optimierung von KI-Tools, die auf spezifische organisatorische Anforderungen zugeschnitten sind. Unternehmen können ihre KI-Systeme optimieren, ohne auf Cloud-basierte Dienste angewiesen zu sein, was zu einer potenziell besseren Leistung und Integration in bestehende IT-Infrastrukturen führt.

3. Reduzierte Latenz: Durch den Betrieb in einem lokalen Netzwerk wird die Reaktionszeit von KI-Systemen erheblich verkürzt, was eine schnellere und effizientere Bearbeitung von Anfragen und Datenverarbeitung ermöglicht.

Wie StorageReview seine lokale KI aufgebaut hat

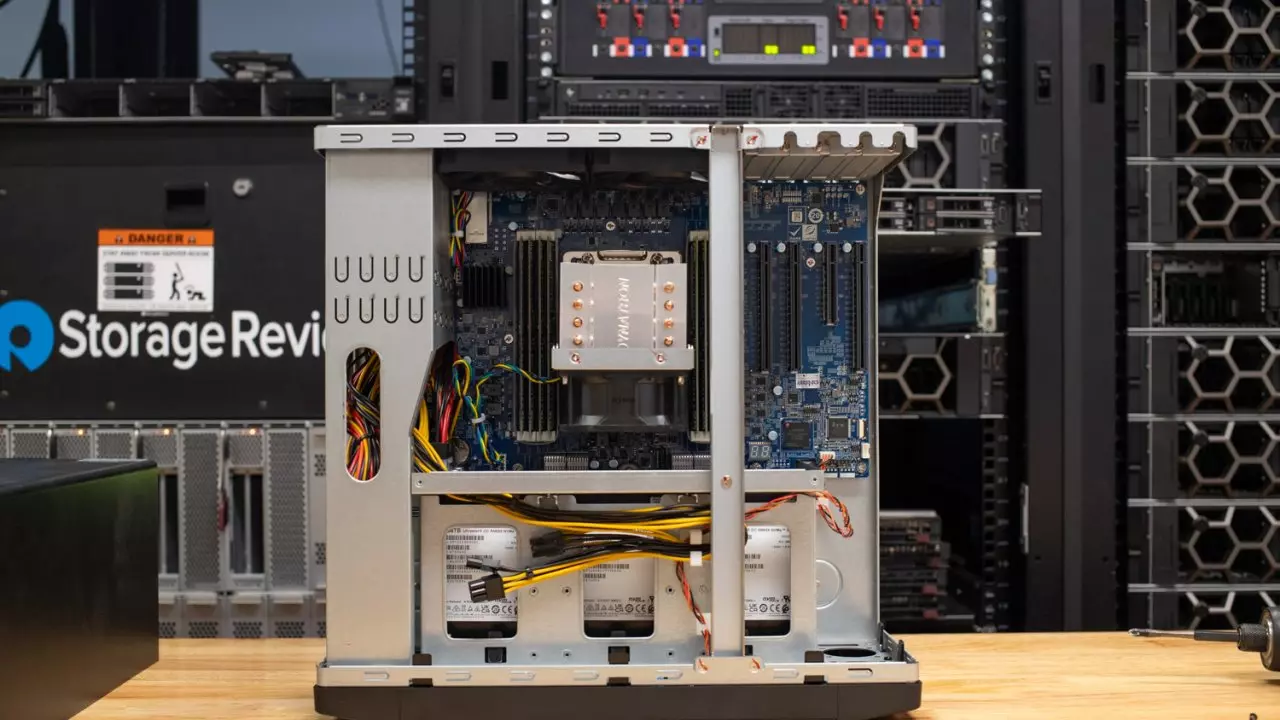

Das Projekt von StorageReview umfasste das QNAP-TS-h1290FX NAS, angetrieben von einem AMD EPYC-Prozessor mit 256 GB RAM und 12 NVMe-Steckplätze. Dieses Hochleistungs-Setup war entscheidend für die Unterstützung der intensiven Rechenanforderungen beim Betrieb einer KI wie ChatGPT.

Entscheidend war die Integration der NVIDIA RTX A4000, einer professionellen Grafikkarte mit Ampere-Architektur, die die Installation eines einzelnen PCIe-Steckplatzes ermöglicht. Das GPU unterstützt NVIDIAs „Chat with RTX“-Lösung und ermöglicht es dem NAS dank seiner Tensor-Kerne, ChatGPT lokal mit erheblicher Rechenleistung auszuführen.

Praktische Anwendungen und Zugänglichkeit

Ein solches KI-Setup eignet sich nicht nur für Großkonzerne, sondern kann bei ausreichenden Ressourcen auch in kleineren Betrieben und sogar zu Hause umgesetzt werden. Zu den Anforderungen zur Replikation eines solchen Setups gehören:

- Eine NVIDIA RTX 30-Serie oder 40-Serie-GPU mit mindestens 8 GB VRAM.

- Mindestens 16 GB RAM und Windows 11.

- Mindestens 35 GB freier Speicherplatz.

Für Interessierte steht das „Chat with RTX“-Tool von NVIDIA zum Download bereit, das sich derzeit in einem frühen Stadium befindet (v0.2) und eine praktische Möglichkeit für Einzelpersonen bietet, mit der Einrichtung ihrer eigenen lokalen KI-Systeme zu experimentieren und daraus zu lernen.

Zusammenfassung

Der Schritt hin zur lokalen KI-Bereitstellung stellt einen bedeutenden Wandel in der Art und Weise dar, wie wir Technologien der künstlichen Intelligenz wahrnehmen und nutzen. Durch das Hosten von KI-Lösungen wie ChatGPT in privaten Netzwerken können Unternehmen mehr Sicherheit gewährleisten und Lösungen an ihre spezifischen Bedürfnisse anpassen, ohne auf die immensen Vorteile der KI verzichten zu müssen.

Dieser Trend eröffnet nicht nur neue Möglichkeiten für Datenschutz und Sicherheit, sondern demokratisiert auch den Zugang zu fortschrittlichen KI-Funktionen, sodass mehr Benutzer das Potenzial der KI-Technologie in ihren eigenen Infrastrukturen erkunden können.