Eines der am häufigsten wiederkehrenden Themen der letzten Jahre war der Anstieg des Energieverbrauchs der verschiedenen Chips. Gleichzeitig haben wir gesehen, wie in vielen Kommentaren die Leute dazu neigen, zu sagen, dass die Steigerung der Energie Unsinn ist. Was wäre, wenn die Tatsache, dass die Neue Chips erhöhen die Stromrechnung war etwas unüberwindbares und eine Folge der Weiterentwicklung der Prozessoren? Deshalb haben wir uns entschlossen, Ihnen das Phänomen zu erklären.

Es besteht kein Zweifel, dass die Stromkosten aufgrund der Geldgier der Politiker und ihrer leicht zu sagenden, aber mit all unserem Geld gemachten Maßnahmen steigen werden. Wir sprechen jedoch nicht über diese Probleme, und obwohl wir wissen, dass die Stromrechnung künstlich gestiegen ist, interessiert uns, zu erklären, warum Grafikkarten immer mehr verbrauchen, wie Prozessoren, RAM Erinnerungen. Das heißt, alle Komponenten in unserem PC.

Dass die neuen Chips die Rechnung in die Höhe treiben, ist unvermeidlich

Wenn wir uns irgendeine allgemeine oder spezialisierte Prozessorarchitektur ansehen, werden wir feststellen, dass mehr als die Hälfte der Schaltkreise, wenn nicht mehr als zwei Drittel, nicht dazu da sind, Daten zu verarbeiten, sondern sie zwischen den verschiedenen Teilen zu kommunizieren. Und wir dürfen nicht vergessen, dass heutige Chips eine oder mehrere Funktionen gleichzeitig haben können, aber sie lassen sich in drei Hauptfunktionen zusammenfassen:

- Um Daten zu verarbeiten.

- Daten übertragen.

- Daten speichern.

Nun, obwohl es für viele kontraproduktiv erscheinen mag, hat die Tatsache der Informationsverarbeitung sowohl in der Anzahl der Transistoren im Prozessor als auch in den wirklich vernachlässigbaren Energiekosten Kosten. Und ein guter Teil des Designs der Prozessoren besteht darin, die Informationen zu den Ausführungseinheiten zu bringen, damit sie sie verarbeiten können. Das Problem ist, dass es aufgrund der Gesetze der Physik heute teurer ist, Bits zu transportieren als alles andere, und eine der Folgen ist, dass Chips die Stromrechnung erhöhen und offensichtlich mehr verbrauchen.

Dies wird als Von-Neumann-Wand bezeichnet, da sie allen Architekturen innewohnt, egal ob es sich um einen Server, ein Mobiltelefon oder eine Videospielkonsole handelt, und sie ist heute das größte Problem für Ingenieure. . Und mehr mit der Notwendigkeit, den COXNUMX-Fußabdruck zu reduzieren.

Das Problem quantitativ erklären

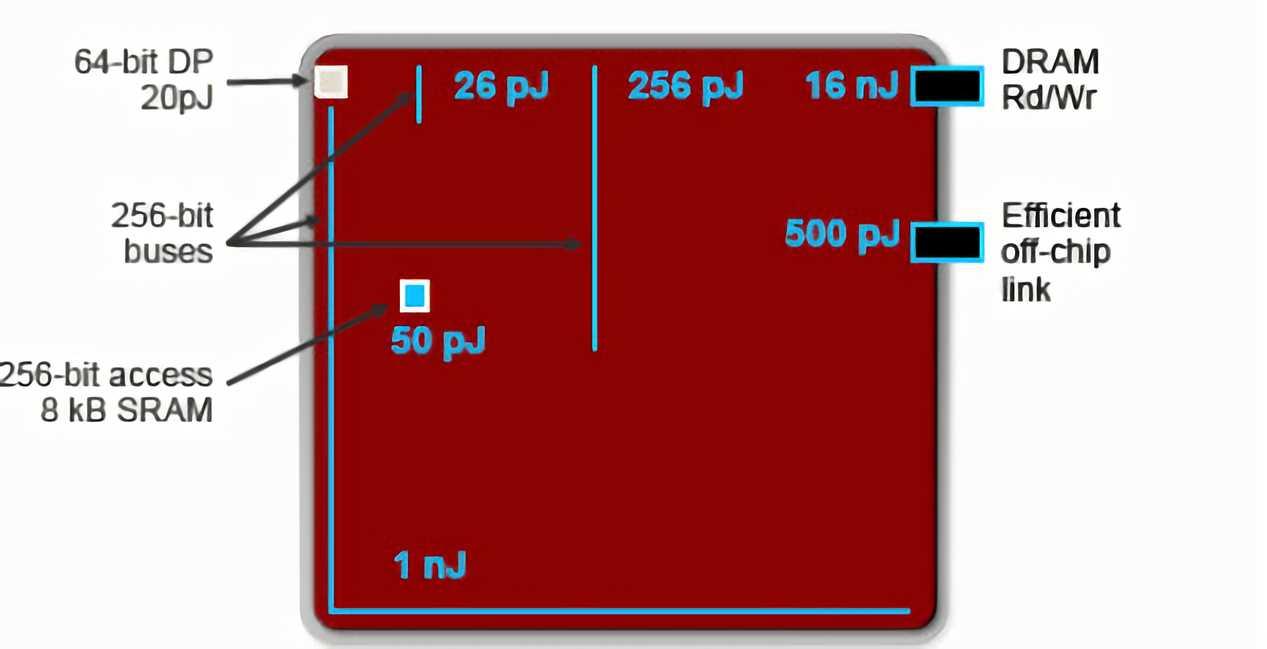

Normalerweise geben wir die Leistungsaufnahme der Chips in Watt (W) an, das sind Joule pro Sekunde. Da die Bandbreite Bytes oder Bits pro Sekunde ist, um beide Begriffe nicht zu verwechseln, besteht eine Möglichkeit, eine einfache Datenübertragung zu messen, darin, zu sehen, wie viele Joule sie verbraucht. Nun, die folgende Grafik verdanken wir Bill Dally, NVIDIA's Chefwissenschaftler und einer der weltweit führenden Experten für Computerarchitekturen:

Nun, wir müssen davon ausgehen, dass ein nJ oder NanoJoule 1000 pJ oder PicoJoule sind. Das heißt, wenn bei der Verarbeitung einer arithmetischen Operation mit doppelter Genauigkeit oder mit 64-Bit-Gleitkomma, je nachdem, wo sich die Daten befinden, der Verbrauch zum Ausführen derselben Operation unterschiedlich ist:

- Wenn die Daten in den Aufzeichnungen sind, dann kostet es nur 20 pJ oder 0.02 nJ.

- Wenn wir auf den Cache zugreifen müssen, um sie zu finden, geht das Ding auf 50 pJ oder 0.05 nJ hoch

- Liegen die Daten hingegen im RAM, dann steigt der Verbrauch auf 16 nJ bzw. 16000 pJ.

Mit anderen Worten, der Zugriff auf den RAM kostet 1000-mal mehr Energie, um dieselbe Operation auszuführen, als die Informationen im Prozessor sind. Wenn wir dazu die interne Kommunikation zwischen den Komponenten eines Prozessors und der externen hinzufügen, haben wir am Ende Chips, die große Datenmengen verarbeiten können, aber gleichzeitig viel Energie benötigen, um zu funktionieren.

Welche Lösungen werden wir in Zukunft sehen?

Im Moment sind es nur Laborlösungen, aber sie haben sich bewährt und könnten unser Verständnis von PCs verändern. Hauptsächlich haben wir zwei verschiedene Lösungen für das Problem.

In der Nähe von Speicherverarbeitung

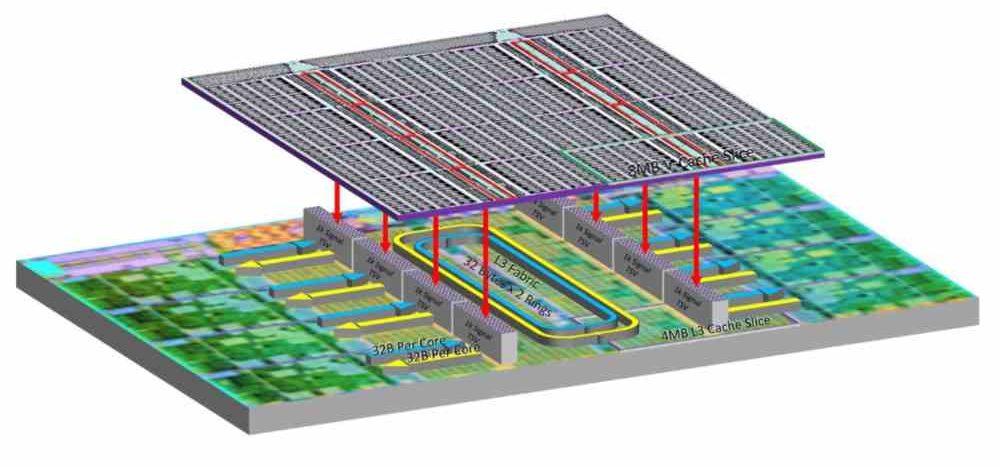

Die erste davon ist die Near-Memory-Verarbeitung, bei der der Speicher näher an die Prozessoren herangeführt wird. Die Idee ist nichts anderes, als den Speicher sehr nahe am Prozessor zu platzieren. Leider können wir nicht die zig Gigabyte RAM einbauen, die wir kurzfristig in PCs sehen werden, sondern eine zusätzliche große Cache-Ebene, die die Kapazität erheblich erhöht Finden Sie die Daten darin und reduzieren Sie den Verbrauch.

Seltsamerweise ist die Strategie, die Größe der Caches zu erhöhen, die von NVIDIA mit seiner Lovelace-Architektur, die L2 von einer Generation zur nächsten um das 16-fache erhöht. Dies ist jedoch nicht genug. Was uns zu dem Schluss führt, dass eine neue Ebene des Gedächtnisses notwendig sein wird. Näher am Prozessor und damit mit weniger Energieverbrauch. Das heißt, in ein paar Jahren werden wir auf unserem PC über schnelles RAM und langsames RAM sprechen. Letzteres ggf. über die CXL-Schnittstelle.

Verarbeitung im Speicher

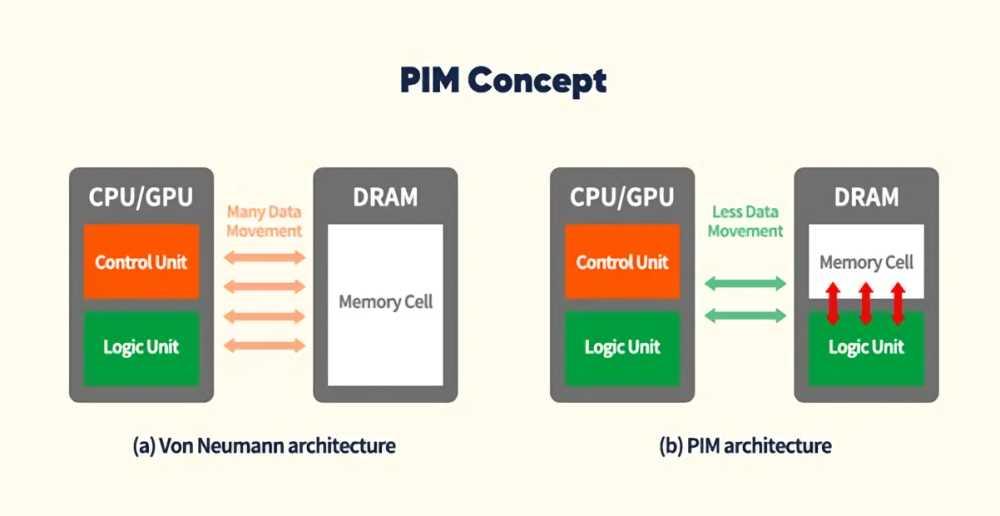

Die zweite Sache ist das, was wir PIM nennen, sie sind selbst keine Prozessoren, sondern Speicherchips mit internen Verarbeitungsfähigkeiten. Das heißt, sie sind immer noch Erinnerungen, aber bestimmte spezifische Algorithmen können in ihnen ausgeführt werden. Stellen Sie sich zum Beispiel vor, dass wir mehrere Anfragen an eine Datenbank stellen müssen, die sich im RAM befindet, um die zu finden E-Mail Adresse eines Kunden. Bei dem herkömmlichen Mechanismus würden wir mehrere Zugriffe auf einen externen Speicher mit geringem Verbrauch benötigen. Auf diese Weise sucht stattdessen der RAM selbst nach den Daten, mit sehr geringem Verbrauch, da nicht extern darauf zugegriffen werden muss und nur Daten an den Prozessor gesendet werden müssen.

Auf diese Weise können wir die Anzahl der Übertragungen zwischen RAM und Prozessor stark reduzieren und dadurch den Energieverbrauch senken. Der Nachteil ist, dass die Anwendungen für dieses Paradigma entworfen werden müssen. Obwohl es notwendig ist, um den Energieverbrauch zu senken und zu verhindern, dass die neuen Chips die Stromrechnung noch weiter in die Höhe treiben.