Es besteht kein Zweifel, dass sogenannte Spezialeinheiten für künstliche Intelligenz zu einer der wichtigsten Hardware-Komponenten geworden sind, insbesondere wenn wir über den Markt für PostPC-Geräte sprechen, auf dem alle ihre SoCs eine Einheit dieses Typs haben, aber dies ist nicht die Fall des PCs, aber das Ding könnte diese Situation dank der komplett ändern Intel AMX-Erweiterungen.

Wenn wir zu diesem Zeitpunkt einen PC haben, müssen wir nur dann eine spezielle Einheit für KI haben, wenn wir separate Hardware kaufen, entweder durch den Kauf eines GPU von dem NVIDIA RTX-Familie oder durch Kauf eines FPGA, das an einem PCI Express-Port montiert ist.

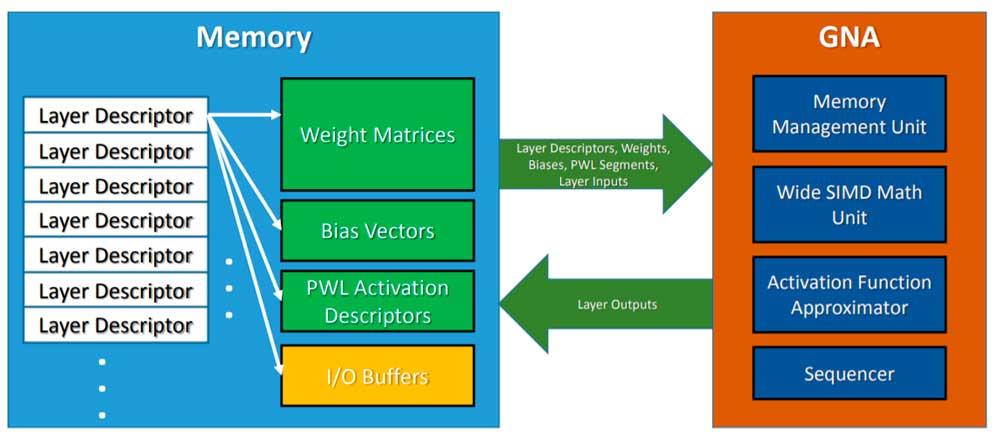

Die Intel GNA, ein Präzedenzfall

Intel verfügt derzeit über ein integriertes Laufwerk namens GNA, das einige AI-basierte Algorithmen ausführen kann, jedoch nicht auf die gleiche Weise wie ein systolisches Array, da GNA ein Coprozessor mit SIMD-Konfiguration ist. Andererseits verkauft Intel auch Lösungen, die auf FPGAs basieren, und mit seinen Intel Xe-GPUs verspricht HP, Einheiten in den Tensor Core-Stil zu integrieren.

Wir sprechen jedoch über die genaue Integration dieser Art von Einheit in a CPU, so dass eine größere Anzahl von Anwendungen diesen Einheitentyp nutzen kann.

Eine Antwort auf Apples M1

Einer der Vorteile von Apple's M1 ist nicht, dass die ARM Satz von Registern und Anweisungen ist energieeffizienter, aber das für bestimmte Anwendungen und Funktionen Die Neural Engine ist äußerst effizient .

Diese Arten von Einheiten sind zu einem Schlüssel auf dem Markt für Smartphones und Tablets geworden, da sie es ermöglichen, sehr komplexe Aufgaben in kurzer Zeit und mit sehr wenigen Ressourcen auszuführen, was dazu geführt hat, dass PC-CPUs in dieser Hinsicht zurückbleiben.

Intel AMX

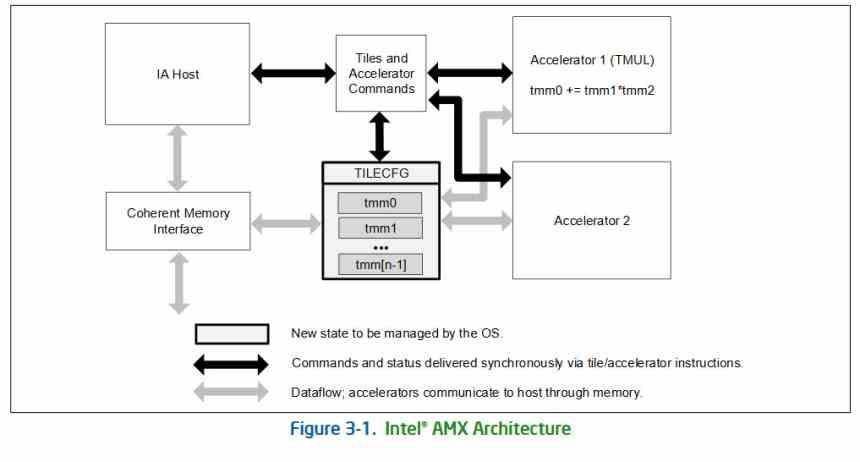

Wie wenn die SIMD-Einheiten die Implementierung neuer x86-Befehle mitbrachten, bringt die Implementierung von Matrix- oder Tensor-Einheiten eine neue Art von Befehl mit sich, AMX oder Advanced Matrix Extensions, die zum ersten Mal mit Intel Xeon-Architektur implementiert werden . Saphir Stromschnellen.

Die Erweiterung fügt zwei zusätzliche Elemente hinzu, einerseits einen zweidimensionalen Datensatz, der aus Datensätzen besteht, die als „Kacheln“ bezeichnet werden, und eine Reihe von Beschleunigern, die auf diesen Kacheln arbeiten können. Diese Beschleuniger teilen den Zugriff auf den Speicher auf konsistente Weise mit den übrigen Elementen der CPU und können verschachtelt mit und parallel zu anderen x86-Ausführungseinheiten arbeiten.

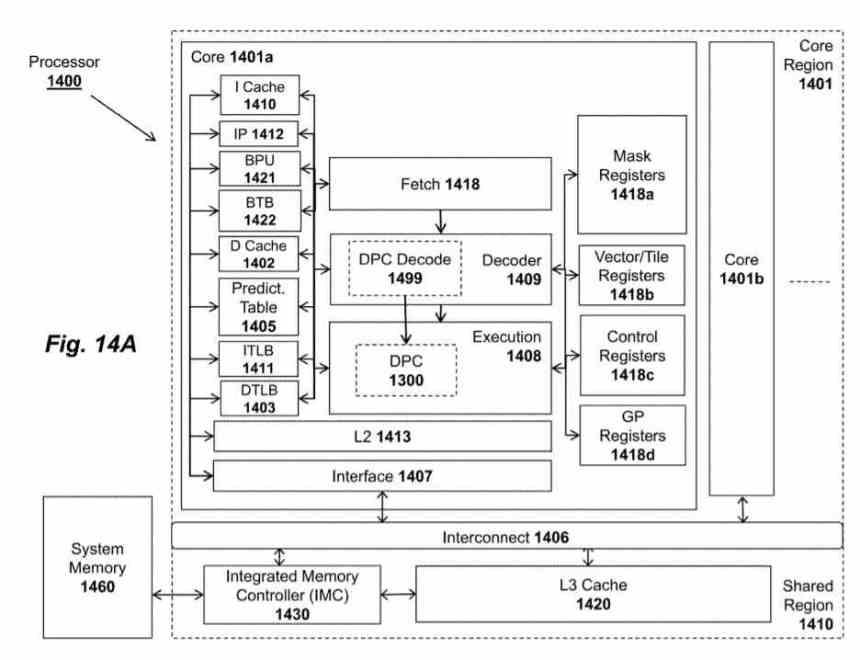

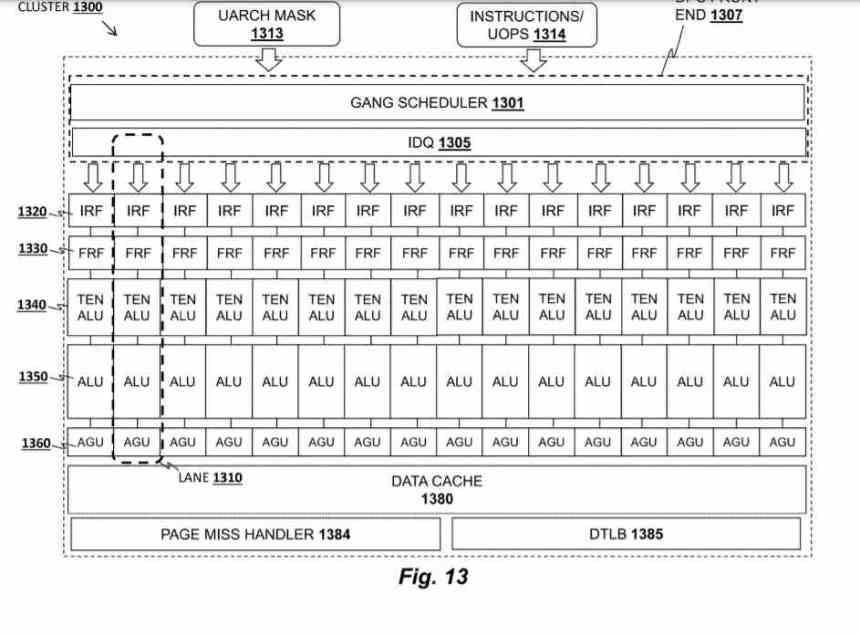

Der Beschleuniger wird als Tile Matrix Multiply oder TMUL bezeichnet. Es handelt sich um ein systolisches Array in Form eines Netzes von ALUs, die in der Lage sind, die FMA-Anweisung (Addition and Multiplication) in einem einzigen Zyklus auszuführen, wobei die Kacheln, aus denen Sie stammen, als Aufzeichnungen verwendet werden im vorherigen Absatz darüber gesprochen.

In AMD Patente, die TMUL-Einheit heißt Data Parallel Cluster und ist eine Einheit, die sich in jedem der Prozessorkerne befindet. Obwohl Intel sie zum ersten Mal in Sapphire Rapids implementieren wird, besteht kein Zweifel, dass wir sie sehen werden Es wurde in Zukunft in den übrigen Intel-Prozessoren implementiert.