Nous avons lu et entendu le concept de goulot d'étranglement à plusieurs reprises, cependant, il y en a un historique qui se trouve dans n'importe quel PC que nous avons entre les mains et qui même des décennies plus tard n'a pas été résolu. Quel est le plus gros goulot d'étranglement qui existe dans nos ordinateurs ?

Un système n'est pas aussi rapide que peut l'être son composant le plus rapide, mais aussi rapide que le permet son composant le plus lent. Que se passerait-il si on vous disait qu'il y a un élément qui est limitant et qui n'évolue pas depuis des décennies, mais des décennies ? Eh bien, le goulot d'étranglement dont nous allons parler n'est pas quelque chose d'une configuration spécifique, mais plutôt une tendance commune à tous les ordinateurs. Quoi qu'il en soit, vous allez le trouver et à l'heure actuelle, il est insurmontable.

Quel est le plus gros goulot d'étranglement sur un PC ?

La façon de mesurer les performances d'un processeur par rapport à un autre est de prendre le même programme dans les deux pour voir combien de temps chacun prend pour l'exécuter. Évidemment, celui qui prend le moins de temps sera le plus rapide. Le problème est que mesurer la performance est difficile aujourd'hui en raison du nombre énorme de facteurs qui existent aujourd'hui. Il faut donc des benchmarks synthétiques et l'utilisation d'applications pour tester les performances du matériel et pouvoir s'en faire une idée quantitative et qualifiante.

Cependant, il existe un goulot d'étranglement qui est général dans tous les systèmes car il est stable depuis tout ce temps. De plus, il jongle sur la corde raide à cet égard depuis des années et à chaque fois un nouveau type de RAM mémoire et son interface est conçue, on veille à ce qu'elle ne soit pas gaspillée et n'affecte pas les performances du processeur central. et avec lui le reste du système.

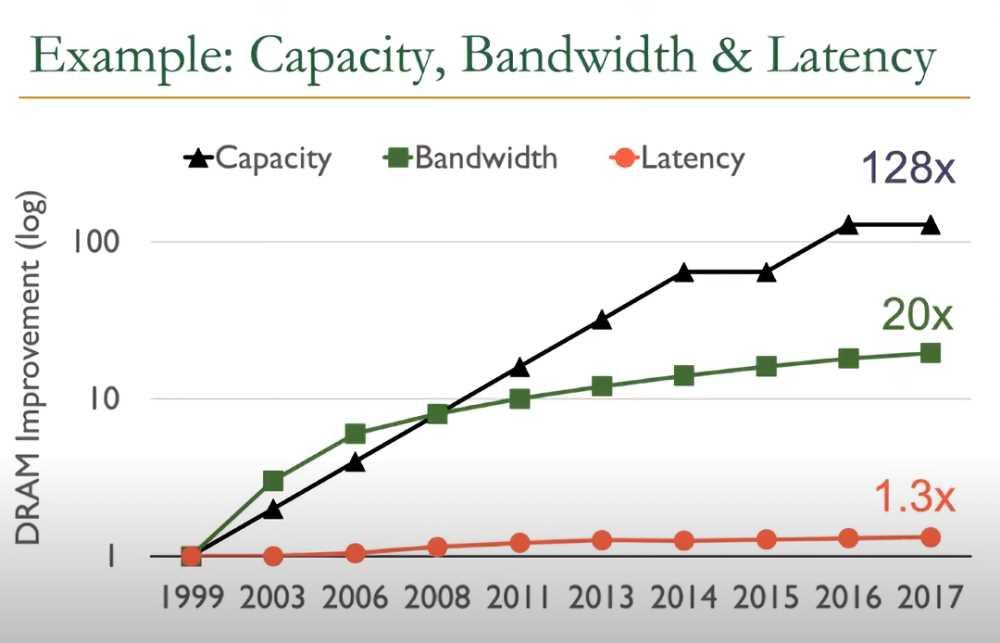

Eh bien, si nous observons l'évolution technique de la mémoire RAM au cours des deux dernières décennies, nous verrons comment :

- Le stockage est passé à 128 fois plus.

- La bande passante est désormais 20 fois supérieure.

- Cependant, la latence n'est que de 30% inférieure.

C'est le dernier point qui représente le plus gros goulot d'étranglement jusqu'à présent. Rapprocher la RAM du processeur serait la meilleure option, cependant, cela rendrait les systèmes plus chers et bien que ce soit aussi une solution pour la consommation, cela signifie rompre complètement avec la manière traditionnelle de fabriquer des PC. Bien que tôt ou tard, nous devrons changer notre façon de comprendre la RAM.

Une bande passante plus élevée ne signifie pas une latence plus faible

Lorsqu'un constructeur donne la bande passante d'une mémoire, ce qu'il fait c'est la donner dans des conditions optimales impossibles et donc d'un seul transfert continu dans un laps de temps. Cependant, les choses ne sont pas si simples et il faut prendre en compte que le contrôleur mémoire doit gérer les accès à la RAM par plusieurs cœurs du processeur et des coprocesseurs associés.

- Le contrôleur de mémoire intégré ou IMC a un nombre maximum de requêtes qu'il peut gérer. Si au final il arrive qu'un montant tolérable soit dépassé, il ralentit, retardant le reste des requêtes et créant de la latence.

- Chaque nouvel accès mémoire par un client différent implique un temps de latence cumulé.

Par exemple, vous aurez vu comment chaque nouvelle génération de Intel et AMD les processeurs prennent en charge une RAM de plus en plus rapide, mais jamais la plus rapide du marché. En effet, il atteint le point où la latence tolérable est dépassée et devient un goulot d'étranglement des performances. De plus, les mémoires overclockées ont des temps de communication plus lents, leur bande passante maximale est idéale pour certaines applications, mais elles souffrent de légers problèmes de latence.