Vor einigen Jahren, als die meisten von uns Monitore mit einer Auflösung von 1024 x 768 oder sogar 1280 x 1024 Pixel hatten, sagten uns die Hersteller, dass es verschwommen aussah und dass wir die beste Bildqualität haben mussten, zu der wir springen mussten Full HD Auflösung (1920 x 1080). Jetzt ist 4K in aller Munde, es stellt sich heraus, dass Full HD verschwommen aussieht und wir uns eine kaufen müssen Monitor mit höherer Auflösung das haben beste Bildqualität . Inwieweit ist das wahr?

Wir können uns das normalerweise als Marketingstrategie vorstellen, und genau das ist es: Sie haben bessere Monitore geschaffen und wollen sie verkaufen. Deshalb sagen sie uns, dass das, was wir jetzt haben, es nicht wert ist und dass wir Geld dafür ausgeben müssen ihr neues Produkt. In Wirklichkeit verbessern wir aber auch die Bildqualität… oder nicht?

Bedeutet eine höhere Auflösung eine bessere Bildqualität?

Wenn wir uns an die empirischen Daten halten, hat ein Full-HD-Bildschirm 1920 x 1080 Pixel oder etwas mehr als 2 Millionen Pixel. Ein Ultra HD-Display hat eine Auflösung von 3840 x 2160 Pixel, etwa 8.3 Millionen Pixel, viermal mehr. Dies bedeutet, dass wir im selben Raum viel mehr Pixel integrieren. Wir werden also a haben höhere Definition , solange es sich um die gleiche Bildschirmgröße handelt.

Und dies ist eine wichtige Information, die Größe des Bildschirms, denn was uns definiert, ist nicht die Auflösung oder die Anzahl der Pixel, sondern die Pixeldichte.

Die Pixeldichte ist der Schlüsselfaktor für die Definition

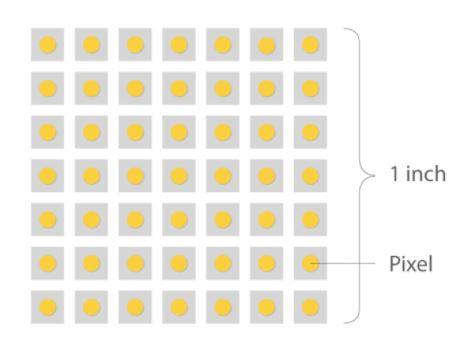

Die Pixeldichte in einem Monitor wird in Punkten pro Zoll gemessen (DPI in Englisch für „Punkte pro Zoll“). Da sie sich jedoch auf die Anzahl der Punkte bezieht, die sich innerhalb einer Zeile von einem Zoll Scan befinden, wurden sie zugunsten von eingestellt PPI (Pixel pro Zoll). Während PPI der richtige Begriff für Monitore ist, werden die beiden häufig synonym verwendet.

Die Pixeldichte ist wichtig, da sie die Bildqualität in dem Sinne bestimmt, dass eine höhere Dichte im Allgemeinen schärfere Bilder erzeugt. Nehmen wir einige Beispiele als Referenz für einen 27-Zoll-Monitor, der heutzutage weit verbreitet und normal ist:

- Ein 27-Zoll-720p-Monitor hätte etwa 54 PPI.

- Ein 27-Zoll-1080p-Monitor hat eine Dichte von etwa 81 PPI.

- Wenn der Monitor eine Auflösung von 1440p hat, würde seine Dichte etwa 108 PPI betragen.

- Wenn wir zur 4K-Auflösung gehen, steigt die Dichte auf 163 PPI.

- Ein 27-Zoll-8K-Monitor hätte eine Dichte von 326 PPI.

Stellen Sie sich vor, Sie haben zwei Monitore nebeneinander und beide mit Full HD-Auflösung, um diese Daten ins rechte Licht zu rücken. Wenn einer von ihnen eine Größe von 32 Zoll hat, während der andere 27 Zoll hat, sehen Sie beim Vergrößern einen offensichtlichen Unterschied in Bezug auf die Größe der Pixel, da beide Monitore zwar die gleiche Größe haben, aber die Dichte der 27 Zoll werden viel größer sein, seine Pixel werden kleiner sein und daher wird es eine bessere Definition liefern.

Ein weiteres Beispiel für die Dichte: Stellen Sie sich einen 1000-Zoll-4K-Monitor vor (übertrieben). In diesem Fall werden wir sehen, dass die Pixel eine beträchtliche Größe haben, da die Dichte sehr gering wäre und daher die Bildqualität schlecht ist, egal wie viel 4K es ist.

Je höher die Pixeldichte, desto besser?

Die Antwort lautet ja und nein. Im Allgemeinen ist eine höhere Pixeldichte besser, da sie eine bessere Bilddefinition bietet, aber es gibt einen bestimmten Punkt, an dem die Leistung abnimmt. Mit zunehmender Dichte werden die beobachtbaren Vorteile dieser höheren Dichte immer weniger deutlich, bis sie für das menschliche Auge nicht mehr wahrnehmbar sind.

Im obigen Beispiel hat der 27-Zoll-Full-HD-Monitor eine Dichte von etwa 81 PPI, während der 32-Zoll-Monitor 69 PPI hat. In dieser Situation kann man mit Sicherheit sagen, dass es beobachtbare Unterschiede zwischen den beiden Monitoren geben wird. Wenn wir jedoch über zwei 24-Zoll-Monitore sprechen würden, beide mit 4K-Auflösung und 8K-Auflösung, wäre der Unterschied nicht wahrnehmbar. und doch hat die Verarbeitung von Bildern mit einer Auflösung von 8K offensichtlich viel höhere Leistungskosten als die Verarbeitung mit 4K.

An diesem Punkt steht der genaue Dichtepunkt zur Debatte, an dem das menschliche Auge keine Veränderungen mehr wahrnimmt. Einige Experten sagen, dass diese Zahl bei etwa 400 PPI liegt, andere sagen 1000, und die meisten Benutzer geben sich mit weniger als 200 zufrieden. Was auch immer dieser Punkt sein mag, es ist offensichtlich, dass es einen bestimmten Zeitpunkt gibt. dass eine höhere Pixeldichte nicht mehr gewürdigt wird.

Bildqualität, gebunden, aber nicht an die Auflösung gebunden

Zurück zum Hauptthema: Laut Dolby hängt die Bildqualität, die Menschen wahrnehmen (weil es sich schließlich um eine subjektive Frage der Wahrnehmung handelt), hauptsächlich von drei Faktoren ab:

- Die Anzahl der Pixel (und ihre Dichte, wie wir erklärt haben).

- Die Rate der Bilder pro Sekunde.

- Die Leistung von Pixeln.

Auf diesen letzten Punkt haben die Hersteller von Monitorfeldern in jüngster Zeit Wert gelegt, da laut Dolby erreicht werden kann, dass diese auch bei gleicher Pixelanzahl einen größeren Dynamikbereich und einen größeren Farbraum darstellen können wird die Wiedergabequalität verbessert. Und was uns betrifft, könnten wir uns nicht mehr einigen, da nicht alles Auflösung ist, wenn wir über Bildqualität sprechen, sondern in Bezug auf die Benutzererfahrung FPS und zugehörige Technologien, wie beispielsweise HDR, einen großen Einfluss haben. .